AI, oftewel Artificiële Intelligentie, is vandaag de dag niet meer weg te denken uit het moderne straatbeeld.

Overal worden we ermee geconfronteerd, of het nu is bij een potje bingen op Netflix, een slimme huisrobot, of (zeer binnenkort) een zelfrijdende auto.

En net omdat het zo alomtegenwoordig wordt, rijzen er steeds meer vragen over de wetgeving hieromtrent.

Wat als er problemen voorvallen door een hapering in de AI, of door een beslissing die de AI zelfstandig heeft genomen?

Wat als een zelfrijdende auto iemand aanrijdt, of als een huisrobot de tenen van een persoon breekt?

Het is voor veel mensen duidelijk dat er hier wat duidelijke wetten over moeten komen, maar dat blijkt niet zo makkelijk te zijn.

Laten we eens kijken wat AI precies is, waar het mis kan gaan, en wat er legaal kan worden gedaan.

Wat is AI?

AI staat voor Artificiële Intelligentie, oftewel Kunstmatige intelligentie.

Het is een wetenschapstak die het menselijke intellect beoogt na te bootsen in machines: soft- en hardware die zelfstandig beslissingen kunnen nemen, data analyseren en conclusies trekken, en daar dan ook actie mee ondernemen – zonder de tussenkomt van een mens.

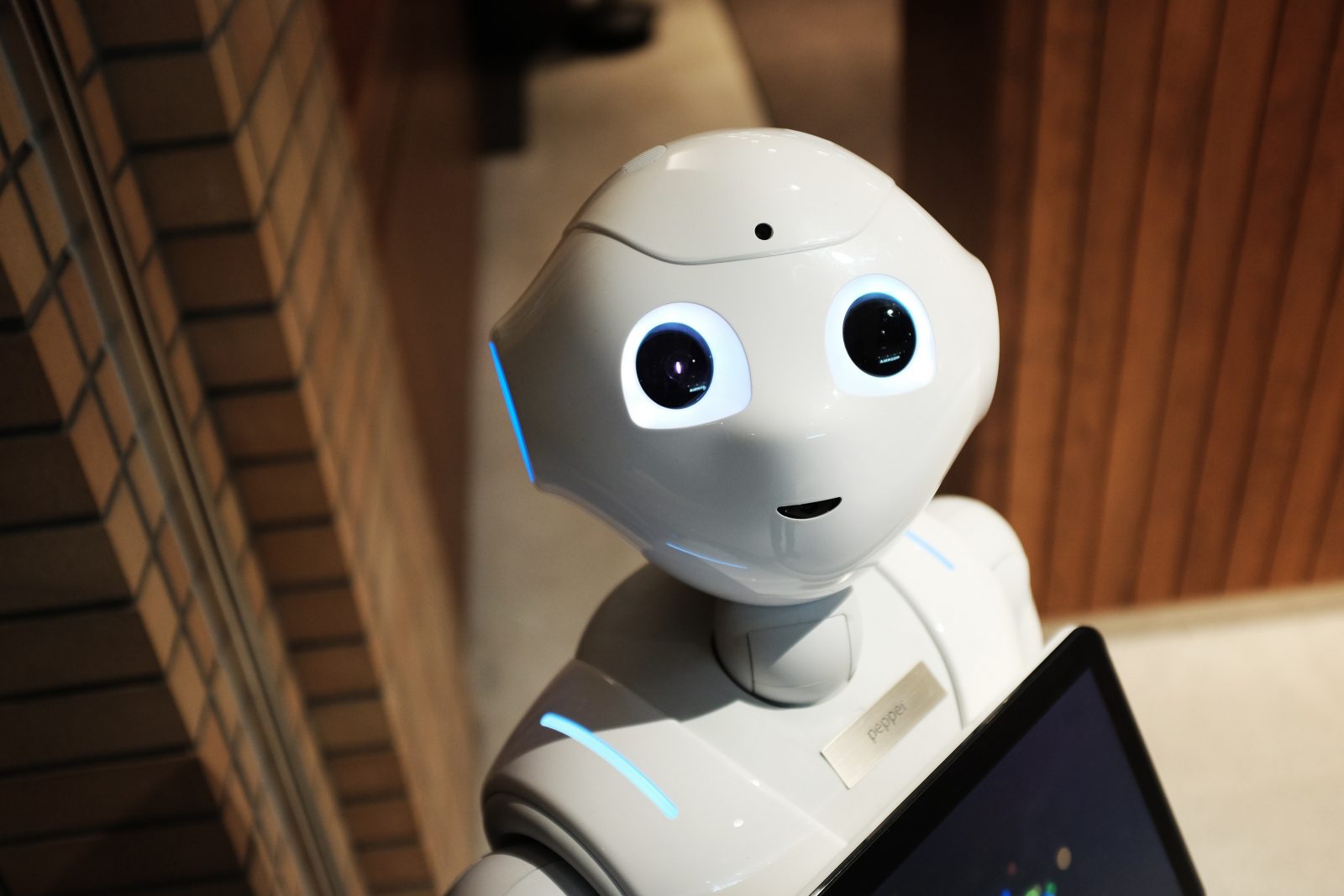

En ja, als je nu denkt aan slimme robots zoals je wel eens ziet in sci-fi films, dan zit je op het juiste spoor.

Zelfstandig opererende robots, slimme drones en zelfrijdende auto’s zijn uitstekende voorbeelden van AI, maar het gaat veel verder dan dat.

Ook smarthome-apparaten zoals een automatische stofzuiger of een zelf-aanvullende koelkast horen hier bij.

Ook in apparaten zoals onze smartphones en tablets en in apps komt Artificiële Intelligentie tegenwoordig altijd voor, denk bijvoorbeeld aan Siri, Google Assistant of Alexa.

Ook Amazon en Netflix maken gebruik van AI in hun app, net als YouTube en andere entertainmentdiensten.

Die nemen je kijkgeschiedenis, analyseren die, en stellen je vergelijkbare series, films, muziek of wat dan ook voor, omdat je dan meer geneigd bent om daar naar te kijken.

Maar het gaat verder, dergelijke AI analyseert ook de kijkgeschiedenis van gebruikers met dezelfde interesses, om jou dan een statistisch waarschijnlijk interessant nieuw aanbod voor te schotelen.

Dit is erg prominent in de gamingindustrie, waarbij mobiele apps het gaminggedrag van gebruikers

analyseren en voortdurend updates en suggesties sturen.

Zo worden je favoriete online casino spellen voorgeschoteld in het online casino gebaseerd op je interesses. Daarnaast gebruiken casino´s AI nog op een andere manier. Zo probeert men valsspelen te voorkomen dankzij AI.

AI registreert gegevens van de gokactiviteiten van de spelers om op die manier onregelmatigheden op te sporen. Op die manier kan AI het account van een speler markeren als een mogelijke valsspeler. Ook de nieuwe casino’s op de markt werken reeds met AI.

Buiten de sector entertainment zijn er natuurlijk ook tal van andere voorbeelden aan te halen, denk aan fitness-apps, die gigantisch veel data van jou verzamelen om je zo goed mogelijk bij te staan met het behalen van je doelen, of financiële apps die je helpen bij het sparen of beleggen.

Huidige regels

De huidige wetgeving rond deze kwestie is ongeveer 40 jaar oud, en stamt uit een tijd dat er amper computers waren, en al zeker geen zelfrijdende auto’s of AI.

Die wetten dekken gebruikers wel een beetje, maar zijn enorm achterhaald en laten heel veel ruimte voor interpretatie, want ze zijn bijlange niet aangepast aan het huidige technologische landschap.

Stel nu: wat als er iets misloopt met een fitness- of beleggingsapp, wat als je data verloren gaat?

Wat als een aanwervingsalgoritme racistische trends begint te vertonen?

Wat als je automatische stofzuiger je kat omver rijdt, of als je automatische auto een voetganger aanrijdt?

Is de soft- of hardware dan verantwoordelijk, of jij, of de fabrikant? Of de kat of de voetganger?

Nieuwe wetgeving

Om een antwoord te geven op deze kwesties, wil de Europese Commissie dat de aansprakelijkheidsregels worden gemoderniseerd.

Deze regels moeten duidelijk maken wie er precies verantwoordelijk is in situaties waarbij een software-update problemen oplevert of als er haperingen voorvallen bij digitale diensten, of andere ongewenste situaties.

Vooral schade en letsel worden aangepakt, maar ook verlies van data, “emotionele schade”, privacyschendingen, discriminatie bij sollicitatieprocedures door gebruik van bepaalde algoritmes, enzovoort.

Eurocommissaries Didier Reynders zegt dat er een balans moet worden gevonden tussen ruimte geven aan het enorme potentieel van nieuwe technologie, en de veiligheid van de gebruikers.

Hij wil dat mensen vaker en voor meer soorten schade door defecte of onveilige producten kunnen

klagen en schadevergoedingen eisen.

Reynders wil ook de bewijslast omkeren.

Waar vandaag de dag gebruikers nog moeten bewijzen dat er een probleem was en dat het bedrijf aansprakelijk is, zullen bedrijven binnenkort wellicht moeten bewijzen dat hun producten veilig zijn en aan de regels voldoen.

Tevens wil hij marktplaatsen zoals Amazon en bol.com aansprakelijk stellen voor de verkoop van onveilige producten als de verkoper niet te vinden is.

Is dat eerlijk? Zal dit niet voor misbruik en problemen zorgen?

Mogelijke problemen

Hoewel dergelijke nieuwe wetten in het kader van “gebruikersveiligheid” worden uitgebracht, is het maar de vraag of dit in het algemeen een goed idee is.

Fabrikanten van zelfrijdende auto’s aansprakelijk stellen als hun creaties iemand aanrijden is wellicht een logische stap, maar in hoeverre is de gebruiker die aanwezig is in de auto en die de route heeft bepaald verantwoordelijk?

Zullen de uitgebreide testprocedures van AI-producten de vooruitgang niet sterk vertragen?

Of wat met een algoritme dat “racistische” neigingen vertoont als blijkt uit duizenden eerdere sollicitaties dat een bepaalde groep mensen gewoon meer kans hebben om aangeworven te worden?

Kan het bedrijf dat het algoritme heeft ontworpen iets worden verweten als hun algoritme wel degelijk de meest efficiënte aanwervingsprocedure ontwikkelt, zelfs als dit nadelig is voor een bepaalde groep?

Hebben ze niet gewoon een correct functionerend product verkocht?

Moeten ze hun AI dus minder efficiënt maken uit vrees om aangeklaagd te worden?

Zetten dergelijke “schadevergoedingen voor emotionele schade” maatregelen de deur niet open voor een voortdurende litanie van klagers en valsspelers die geld willen persen uit bedrijven?

Hoelang zullen technologiebedrijven dergelijke zaken verdragen voor ze ermee stoppen?

En dat is het grootste probleem met dergelijke wetten: als ze te streng zijn gaan ze innovatie gegarandeerd beperken.

Producenten zullen zich aan heel wat meer regels en langdurige procedures moeten houden, wat de technologische vooruitgang van de hele maatschappij vertraagt.

Daarnaast zullen ze zich ook zo goed mogelijk willen indekken uit vrees om aangeklaagd te worden, en misschien producten ontwikkelen die tot heel wat minder in staat zijn dan in feite mogelijk is.

Gaan bedrijven niet uitwijken naar landen met wat lossere wetten als het klimaat hier te beperkend wordt?

Hoe is dat goed voor onze (tegenwoordig erg logge) economie?

Maar kijk, het is om een antwoord te geven op deze vragen dat de voorstellen werden ingediend, en hopelijk heeft de Commissie zich over alle verregaande implicaties van de kwestie gebogen.

Momenteel moeten de voorstellen worden goedgekeurd door de lidstaten en door het Europese Parlement, wat nog een heel tijdje kan duren.